Im Rahmen des Schwerpunkts zu Artificial Intelligence (AI) der Plattform Industrie 4.0 beleuchten wir unterschiedliche Aspekte der Produktion und die Auswirkungen von AI auf diese. Ende September lag der Fokus daher auf dem Thema Qualitätssicherung, welches in einer Sitzung der EG Forschung, Entwicklung und Innovation aus unterschiedlichen Blickwinkeln beleuchtet wurde.

Passende Daten und Modelle als Grundbedingung

Im ersten Vortrag von Markus Steindl, Data Scientist der RISC Software GmbH in Hagenberg, wurde zuerst das Thema Datenqualität im Allgemeinen adressiert: Wenn es Probleme mit dem Modell oder mit der Qualität der genutzten Daten gibt, dann wird das Resultat nicht wünschenswert sein – „Garbage In – Garbage Out“ ist dabei ein wichtiges Paradigma. Die Aufbereitung von Daten macht daher den größten Teil des Arbeitsaufwandes für Data Scientists aus. Anschließend ging Hr. Steindl auf verschiedene Modelle im Umgang mit Daten ein und erklärte, warum „Overfitting“ (Modell zu wenig aussagekräftig) und „Underfitting“ (Modell zu komplex) im Bereich der Qualitätssicherung vermieden werden müssen. Am Ende wurden zwei Anwendungsfälle in den Bereichen Produktion (Predictive Maintenance) und im Gesundheitsbereich (Bilderkennung) betrachtet. In beiden Anwendungsfällen ist die Auswahl passender Modelle und Datensätze zentral für den Erfolg eines Projekts.

Einsatz von Daten in der Produktentwicklung

Wenn die Datenqualität sichergestellt und die passenden Modelle gefunden sind, dann ermöglicht dies „Data Driven Engineering“. Dabei fließen, so Wolfgang Kienreich, Director Business & Markets am Know-Center in Graz, im Optimalfall Daten aus den einzelnen Produktionsschritten innerhalb des Product Development Life Cycle in die Design-Prozesse zurück und können so wiederum die Produktqualität verbessern. Hr. Kienreich präsentierte anschließend zwei Use Cases, in denen diese Denkweise zum Einsatz kam. Unter anderem wurden in einer Lackiererei die für die Produktqualität wesentlichen Parameter identifiziert und dadurch eine Kostenreduktion erzielt.

Die „intelligente Weiche“ als datengetriebene Produkt-Innovation

Auch bei der voestalpine ist Qualitätssicherung ein wesentliches Thema. Innerhalb der voestalpine Railway Systems arbeitet man aktuell an der „intelligenten Weiche“, eine Idee, die unter anderem von Data Scientist Robert Bernerstätter vorangetrieben wird. Ziel ist es dabei, präventiv zu erkennen, wann die Wartung einer Weiche notwendig und welche Wartung erforderlich ist. Diagnosen und Prognosen finden dabei auf Basis der bestehenden Monitoringhardware bereits statt. In Zukunft soll die intelligente Weiche mit zusätzlicher Sensorik weitere Anwendungsfälle in den unterschiedlichen Bereichen der Instandhaltung ermöglichen. Wichtig ist dabei auch „Data Story Telling“: AI und Visualisierungs-Tools sind für Infrastrukturbetreiber wichtig, damit das Produkt richtig verwendet wird.

Qualitätsverbesserungen durch Simulation und „Ratteralarm“

Die konstante Weiterentwicklung im Bereich der Qualitätssicherung beschäftigt auch die FILL GmbH in Gurten im Innviertel. Mit Hilfe von Daten werden bei FILL die Produktionsanlagen optimiert: Schon seit 2010 verwendet man beispielsweise Simulationssoftware inklusive einer eigenen Maschinenbibliothek, um die Produktqualität bereits in der Konzeptphase zu steigern. Wie dies in der Praxis gelingt, wurde von Stefan Murauer (Teamleiter Software Digitale Produkte) anhand einer Live Demo erklärt. Auch auf den Einsatz des digitalen Zwillings in der Praxis wurde eingegangen: Wenn es z.B. zu einem Ausfall der Maschine kommt, dann kann gemeinsam mit den MitarbeiterInnen im Nachhinein ermittelt werden, was die Gründe dafür waren und mit welcher Vorgehensweise ein solcher Ausfall in Zukunft verhindert werden kann. Michael Gillhofer (Data Scientist) ging im Anschluss darauf ein, wie mit Hilfe von Daten die Stabilität des Fräsprozesses gewährleistet werden kann. In anderen Worten: Wie können Daten Probleme vorhersagen, bevor die Maschine zu rattern beginnt? Dabei werden Muster in den Messdaten der FILL-Maschine erkannt und dadurch ein „Ratteralarm“ kreiert, der die Qualität der Maschine im Einsatz beim Kunden sicherstellt.

Qualitätssicherung im Geschäftsmodell

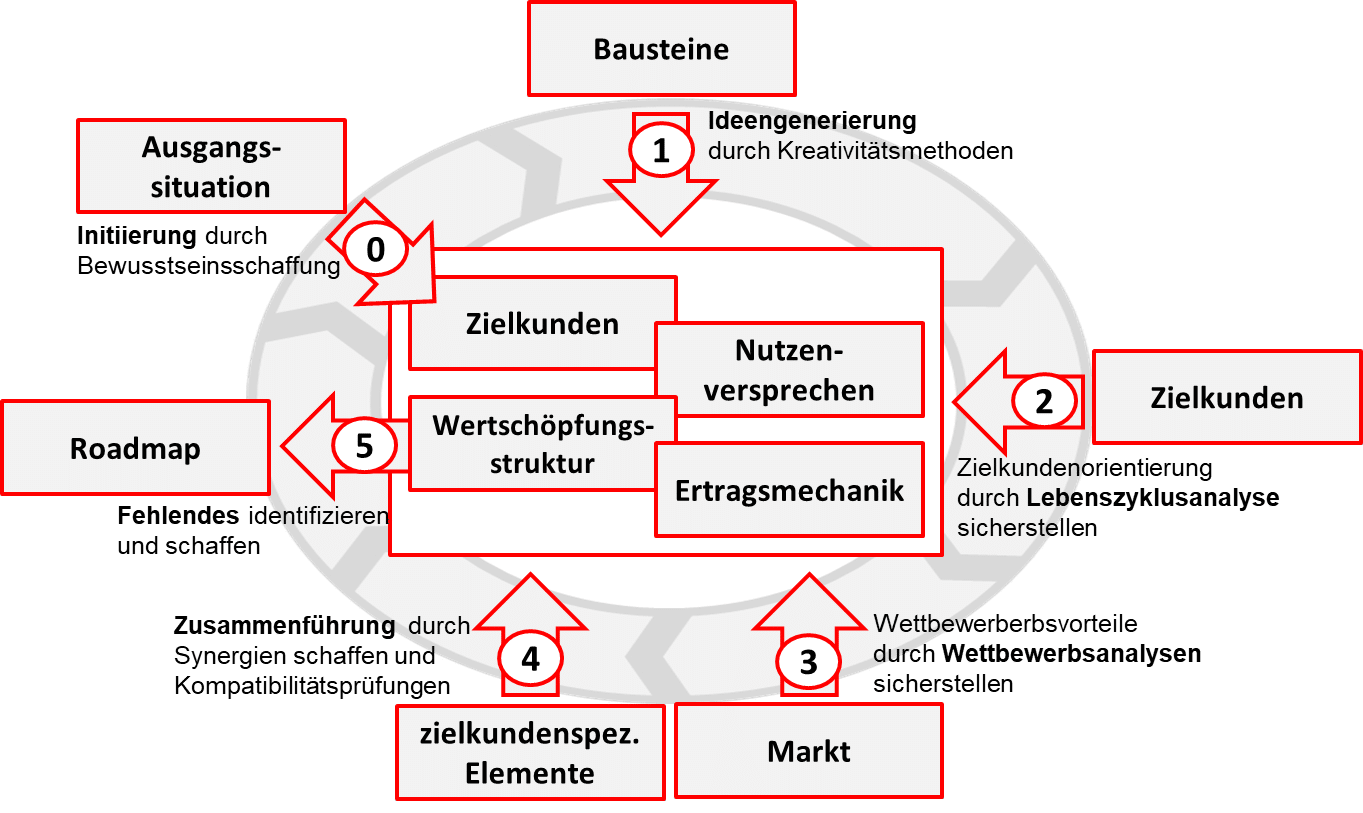

Wie das Thema Qualitätssicherung bei der Entwicklung von Geschäftsmodellen mitgedacht werden erläuterte schließlich Manuel Brunner, Leiter des Center of Excellence for Smart Production an der FH Steyr. Wichtig ist dabei ein kontinuierlicher Verbesserungsprozess. Dieser kann jederzeit (z.B. jedes Jahr) in Unternehmen initiiert werden, um die Qualität der Vorgehensweise im eigenen Geschäftsmodell regelmäßig zu überprüfen. Ein solcher Transformationsprozess wird in der folgenden Grafik beschrieben:

Um einen solchen Prozess erfolgreich durchzuführen sind gute Kundenbeziehungen wichtig – neue Geschäftsmodelle können z.B. mit Kunden, bei denen viel Potenzial und eine langfristige Beziehung vorhanden sind, getestet und erprobt werden. Den Kunden kann man durch Daten auch besser kennenlernen – dafür müssen diese, wie anfangs erwähnt, natürlich erhoben und mit den richtigen Methoden ausgewertet werden.

In der 17. Sitzung der ExpertInnengruppe Forschung, Entwicklung und Innovation wurde das Thema Qualitätssicherung ausgiebig besprochen, sowohl wissenschaftliche als auch wirtschaftliche Perspektiven wurden aufgezeigt.

Wir bedanken uns bei allen, die an der Sitzung teilgenommen haben und insbesondere bei den Vortragenden für ihre wertvollen Inputs!

Für weiterführende Informationen zu den Vorträgen bzw. zur Arbeit der ExpertInnengruppe F,E&I wenden Sie sich gerne an michael.fellner@plattformindustrie40.at.